Як правильно налаштувати Robots.txt для сайту у 2025 році: покроковий гід

Що таке файл robots.txt і навіщо він потрібен?

Файл robots.txt — це текстовий файл, який знаходиться в кореневій директорії сайту та керує доступом пошукових роботів до сторінок вашого ресурсу. За допомогою цього файлу ви можете дозволяти або забороняти сканування певних розділів сайту, що впливає на індексацію та SEO.

Основні правила запису в robots.txt

Формат запису у файлі robots.txt простий і складається з двох ключових директив:

- User-agent: вказує, до якого пошукового робота застосовується правило.

- Disallow: вказує, яку сторінку або розділ сайту заборонено сканувати.

Наприклад:

Ми рекомендуємо:

Щоб заощадити час і отримати якісний результат, скористайтесь нашими перевіреними рішеннями:

User-agent: * Disallow: /admin/

Рекомендації для налаштування robots.txt у 2025 році

- Забороняйте сканування сторінок з параметрами, щоб уникнути дублювання контенту.

- Не блокуйте важливі сторінки для індексації, такі як головна, статті, категорії.

- Обов’язково вказуйте посилання на актуальну карту сайту (sitemap.xml).

- Регулярно перевіряйте файл robots.txt через Google Search Console.

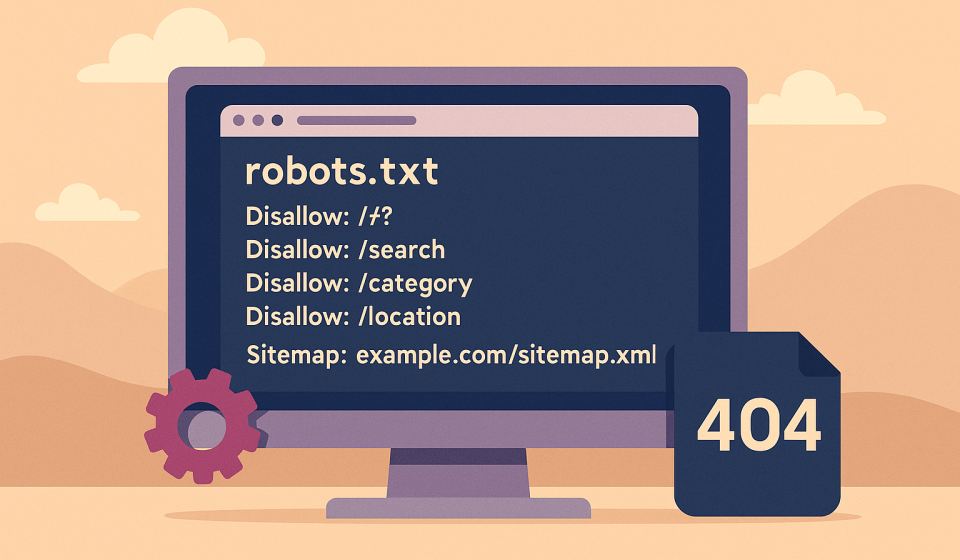

Приклад правильного robots.txt для інформаційного сайту

User-agent: * Disallow: /*? Disallow: /search Disallow: /category Disallow: /location Sitemap: https://webmastera.kiev.ua/sitemap_index.xml

Як перевірити правильність налаштувань

Перевірити коректність файлу robots.txt можна у Google Search Console, розділ «Перевірка файлу robots.txt». Там ви побачите, чи блокує ваш файл потрібні сторінки і чи не обмежує доступ до важливих розділів.

Висновки

Файл robots.txt — це простий, але дуже важливий інструмент для правильного управління індексацією сайту. У 2025 році його значення для SEO залишається незмінним. Налаштуйте його грамотно, щоб забезпечити пошуковим системам доступ лише до корисного та релевантного контенту.